LAMA - Linked Annotations for Media Analysis

LAMA heißt das innerhalb des Forschungsprojekts Telling Sounds entwickelte Tool zur Analyse von audiovisuellen Medien. Konkret hilft das Tool dabei, audiovisuelle Quellen („Clips“) zu analysieren, zu kontextualisieren und Querverbindungen zwischen diesen herzustellen. Hierfür werden die Clips im System angelegt und zuerst die Metadaten eingegeben (URL, Dauer, Titel, etc.). Danach können Annotationen vorgenommen werden. Diese geben beispielsweise an, welche Themen, Personen, Musikstücke oder Klänge („Entities”) im Clip vorkommen. Hierbei wird zwischen Deskription und Interpretation unterschieden. Bei deskriptiven Angaben sind die angegebenen Dinge eindeutig zu sehen bzw. zu hören, bei interpretativen Angaben handelt es sich um Bezüge, Themen und Überbegriffe, welche aus dem Kontext abgeleitet werden. Jede einzelne Angabe, die gemacht wird, kann nach Wunsch ausführlich beschrieben werden. Weiters besteht im Tool die Möglichkeit, Annotationen mit einem Timecode zu versehen, um die entsprechende Stelle schnell wiederzufinden. Darüber hinaus können kleinere Unterabschnitte in Segmenten, die ebenfalls durch Timecodes gekennzeichnet sind, ausführlich beschrieben werden. Dieses wertvolle Analysewerkzeug ermöglicht es, einzugrenzen, in welchen Abschnitten etwas vorkommt bzw. zu erkennen, wenn gewisse Entities gemeinsam vorkommen.

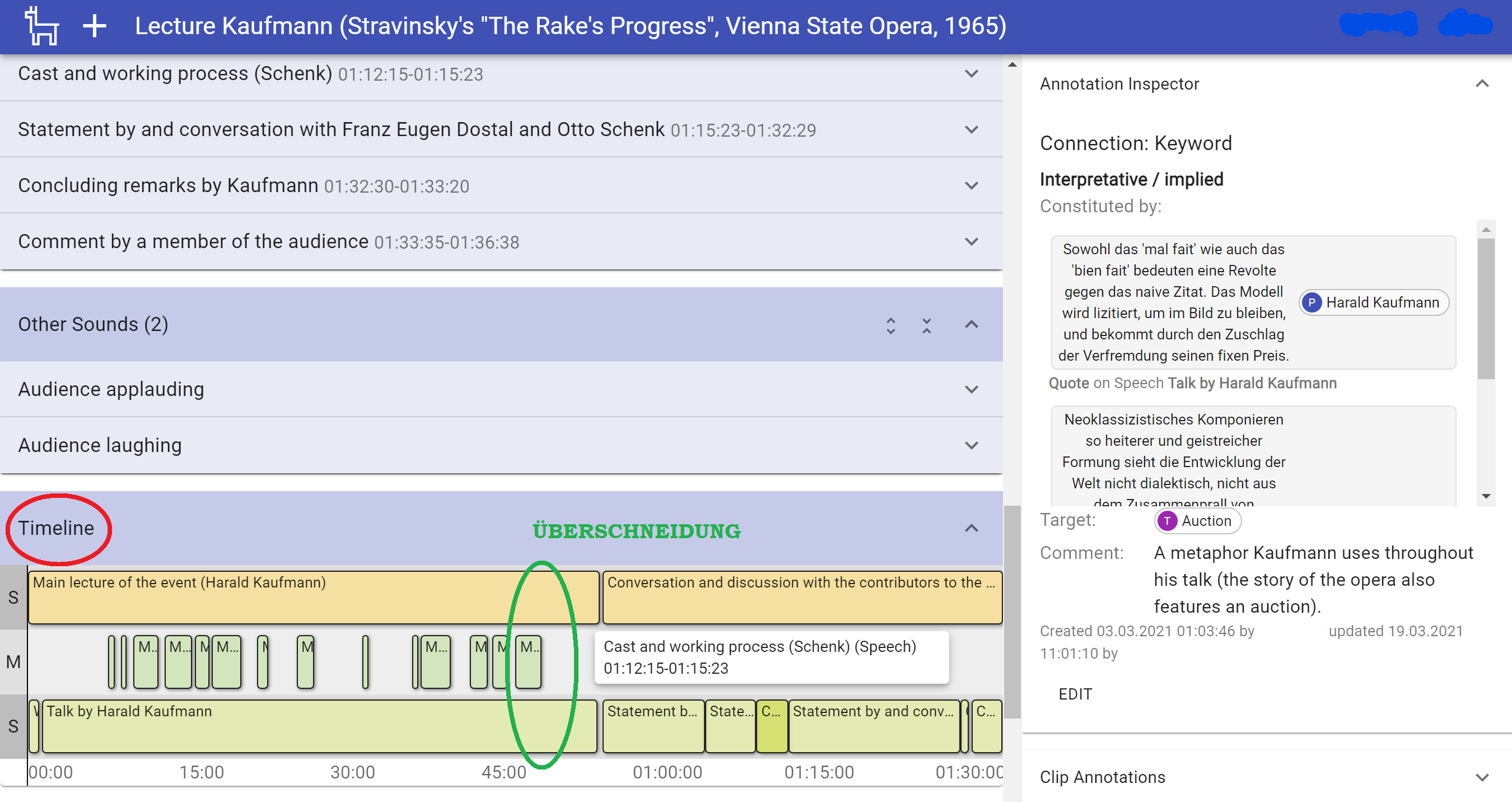

Eine Besonderheit des Tools stellt die Möglichkeit dar, komplexe (Ab)Fragen zu stellen. So kann beispielsweise danach gefragt werden, welche Entities gemeinsam vorkommen oder welche Themen mit Musik unterlegt wurden. Die Recherchen zu spezifischen Forschungsfragen wird so ungemein erleichtert und es kann deutlich mehr Material in Hinblick auf das eigene Forschungsintresse in viel kürzerer Zeit durchsucht werden. Um eine bessere Übersicht zu bekommen wurde zudem daran gearbeitet, die Eingaben auch visuell aufzubereiten. So können all jene Ausschnitte, welche einen Timecode erhalten haben auf einer Timeline dargestellt werden. Dadurch ist auf einen Blick zu sehen, welche Annotationen - beispielsweise spezifische Geräusche, ein Musikstück, Sprache etc. - sich in einem Clip überlappen. Simultanität wird dadurch sichtbar, man erkennt, was gleichzeitig passiert. Dies lässt Überschneidungen deutlich zu Tage treten (vgl. Abbildung 1)

Derzeit wird an einer weiteren Funktion gearbeitet. Um Zusammenhänge zwischen Entities besser fassbar zu machen, sollen diese in Zukunft als "Netzwerke" angezeigt werden können. So können Personen, Themen, Orte etc. als einzelne Entities untereinander vernetzt werden, um größere thematische Zusammenhänge erkennbar zu machen.

Abbildung 1